Ollama-开源跨平台大模型工具

官网地址:Ollama官网

安装

官网首页点击download即可选择对应平台的Ollama进行安装,下载慢的话可选择尝试挂上科学上网

Ollama默认是安装到C盘的用户默认安装目录下的,如果想要移动到其他的盘下,请参考此文章

需要先移动文件夹,再执行命令,会在原位置创建一个类似快捷方式的快捷访问,但是实际存储位置已经改为修改后的盘符位置,需要修改对应的文件夹名字为命令对应的文件夹名

下载模型

Ollama官网左上方导航栏点击modules即可跳转到模型列表页,点击对应模型进入详情页,如需要下载DeepSeek-R1的模型,根据自己的电脑配置选择相应大小的模型,如我的电脑配置为 内存为D5 7600 32G*2 ,显卡为7900xt,显卡显存大小为20G,是足够运行32b蒸馏模型的

cmd运行如下命令即可开始下载模型

1 | ollama run deepseek-r1:32b |

下载完成后即开始加载模型,可以开始对话

如果报错未成功加载模型,则需要检查配置,出现报错的可能性很多,

1 | Error: llama runner process has terminated: error loading model: unable to allocate CUDA0 buffer |

如配置不足够运行该模型,完全爆显存,或者显卡的驱动未更新,我目前经历过的就是显卡驱动未及时更新,运行14b能成功,运行32b无法成功加载,更新显卡驱动到最新版之后,32b模型能成功运行,第一次尝试可先选择1.5b模型运行

模型配置需求

如果是windows系统

一般 内存大小为16G,显卡显存大小为8G,可成功加载最大8B的蒸馏模型

内存大小为16G,显卡显存大小为10G或者12G,可成功加载14B蒸馏模型

内存大小为20G+,显卡显存大小至少20G,可成功加载32B蒸馏模型

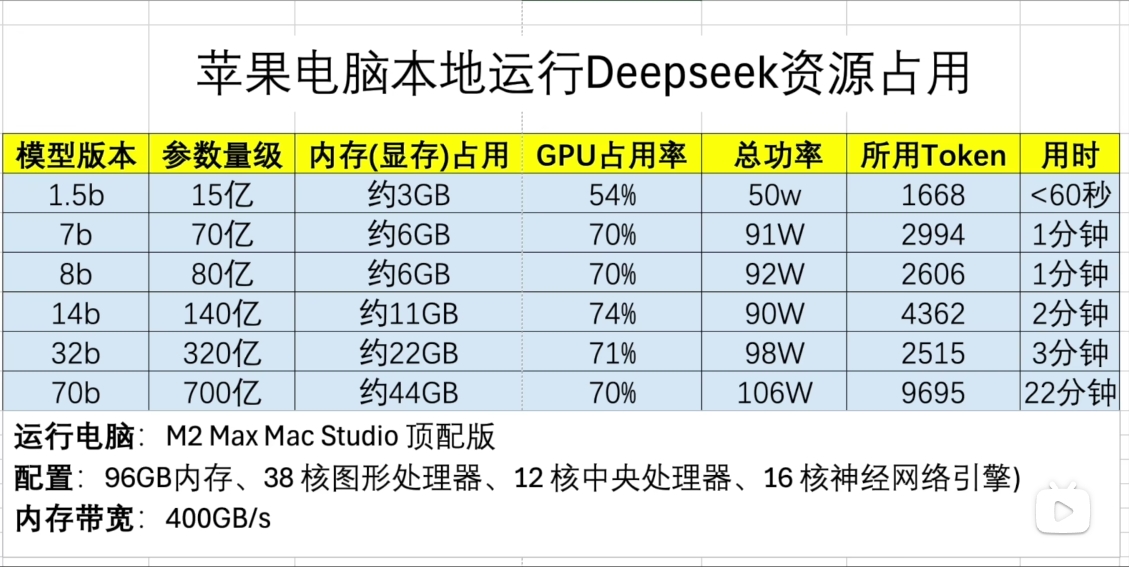

如果是mac系统

可参考如图

Ollama相关命令

1 | ollama list // 查看加载过的模型列表 |

本文作者:Ray

本文链接:Ollama本地部署DeepSeek-R1模型

如有错误,请及时评论或者 B 站私信哦~

最后更新于:2024/12/16